(Photo/Getty Images)

爆増するデータを数十年にわたって保存しなければならない現実

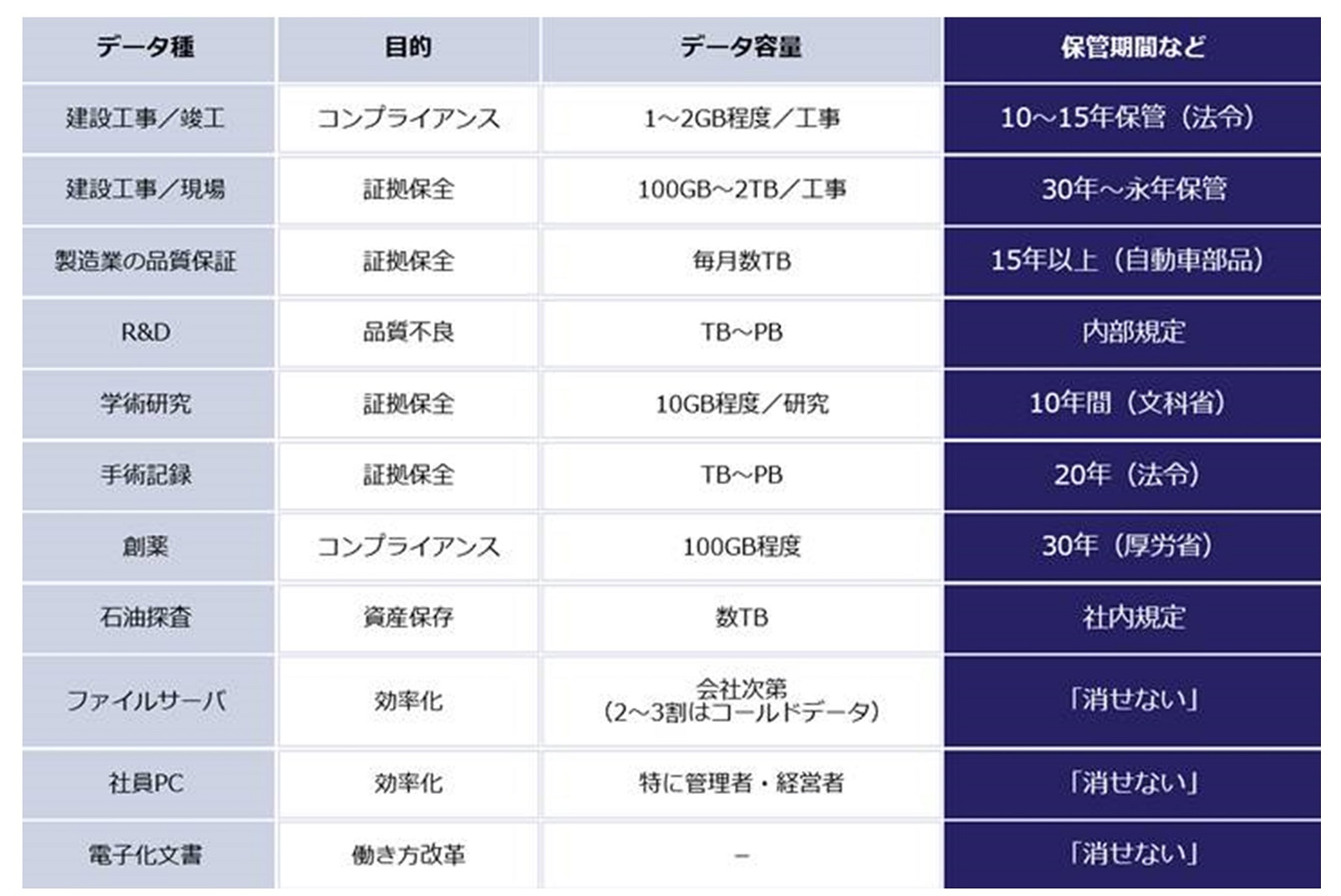

近年、あらゆる産業で「データの大容量化」が課題となっている。研究・開発分野ではスーパーコンピュータの活用が増え、設計・製造分野では、性能向上によってCAD/CAEデータの容量が以前より大きくなっている。また、さまざまなシーンで活用されるようになった画像処理技術も、AI/深層学習の進展によってデータ量が増え続けている。このような流れを受け、各国で大容量データに関する法令や指針が示されている。創薬分野では「GCP」(医薬品の臨床試験実施基準)と呼ばれるガイドラインがあるが、EUでは治験後25年間のデータ保管が規定されている。製造業界では証拠保全のために15年の品質データ保管が求められており、建設現場では永年保管といった厳しい保管期間の例もあるようだ。これは企業だけでなく、公共機関でも同様だ。時効撤廃によって、警察も事件解決まで半永久的なデータ保管が求められるようになった。

内外の要因でデータ容量が増大し、長期保管が必要になると、保有データの安全性が脅かされることになりかねない。ランサムウェアによって身代金を要求されたり、データの改ざんや剽窃など、セキュリティ面の危険もある。さらには、地震など自然災害による不測の事態で、データを消失してしまう恐れもある。

このようなリスクに対し、重要なデータを安全かつ安価に長期保管するための解決策がいま求められているのだ。

この記事の続き >>

・大容量のコールドデータ保存、方法によって数億円のコスト差

・データの長期保管先を選ぶときにチェックすべき点

・複雑なハイブリッド環境でも効率的な運用

からの記事と詳細 ( 軽視していると「20年で数億円」の損。爆増するデータ、どう保管するのが正解? - ビジネス+IT )

https://ift.tt/3l6xITM

0 Comments:

Post a Comment